Nvidia continua a espandersi nel campo delle intelligenze artificiali e l’ultima pedina aggiunta alla sua scacchiera è una società israeliana chiamata Run.AI. Ecco un riassunto di che sta succedendo.

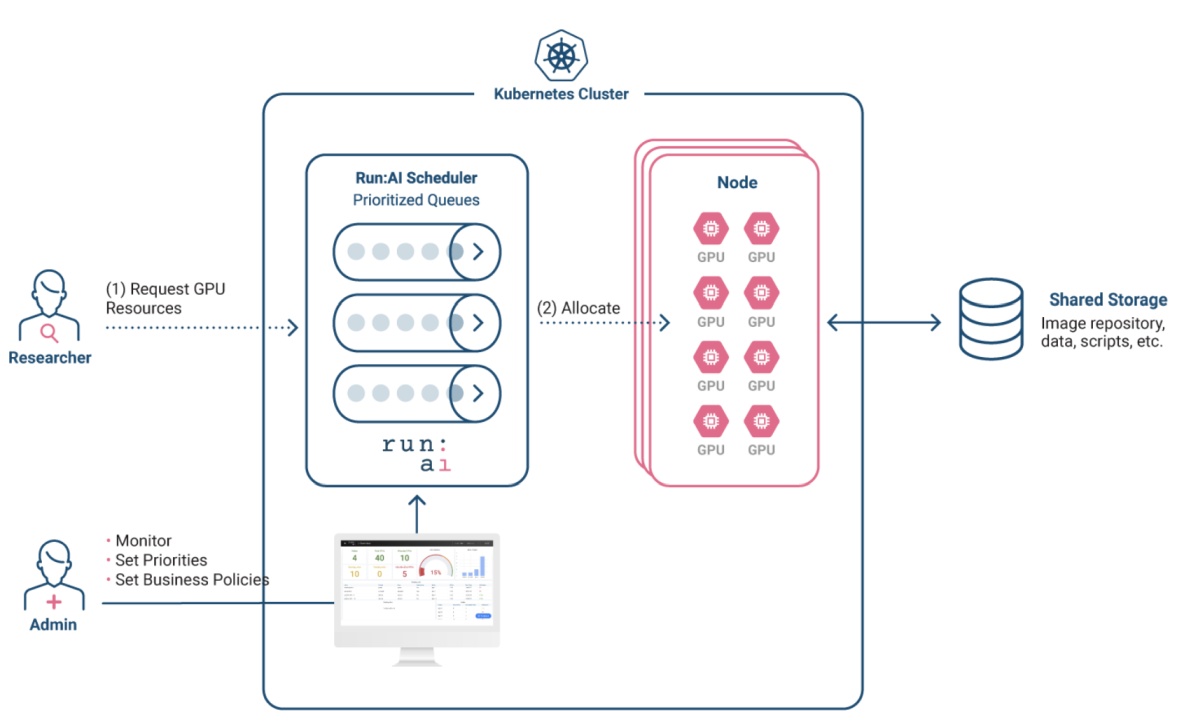

Nvidia sta cercando di acquisire Run:ai, una società con sede a Tel Aviv che ha come business model la semplificazione per sviluppatori e team operativi dei processi di gestione e ottimizzazione dell’infrastruttura hardware per l’intelligenza artificiale.

I termini dell’accordo non sono ancora stati pubblicati in chiaro ma secondo quanto riportato dalle fonti sentite poi dal magazine Techcrunch, il prezzo dell’acquisto è intorno a 700 milioni di dollari; secondo CTech, invece, i negoziati avanzati che stanno avendo luogo porteranno Nvidia a pagare oltre 1 miliardo di dollari per l’azienda.

Cosa ci farà Nvidia di Run:ai?

Secondo quanto scoperto da Techcrunch Nvidia vuole continuare a offrire i prodotti e servizi di Run:ai non modificandone il modello di business e vuole investire nella roadmap di prodotti dell’azienda integrandola all’interno della sua piattaforma DGX Cloud AI; quest’ultima è una piattaforma B2B per clienti aziendali che permette a questi ultimi di avere accesso a infrastrutture di calcolo o software specializzati nell’addestramento di intelligenza artificiale generativa e/o simili.

Non è tutto: I clienti dei server e delle workstation Nvidia DGX e del DGX Cloud avranno anche accesso alle capacità di Run:ai per meglio gestire i propri carichi di lavoro attraverso la distribuzione delle risorse delle intelligenze artificiali generative su più sedi di data center.

Omri Geller, CEO di Run:ai, ha dichiarato:

“La collaborazione tra Run:ai e Nvidia è cominciata nel 2020 e fin da subito abbiamo capito di condividere una grande passione per massimizzare l’efficiacia delle infrastrutture dei clienti; attraverso il nostro assorbimento in Nvidia non vediamo l’ora di continuare questo percorso assieme.”

Run:Ai – questione di identikit

La storia di Run:ai parte da due figure: Omri Geller e Ronen Dar, due studenti della Tel Aviv University che insieme al loro professore Meir Feder hanno cercato di costuire una piattaforma con lo scopo di spezzettare i modelli di intelligenza artificiali in modo da farli funzionare in parallelo su hardware in contesti on-premi, in cloud pubblici o con altri sistemi ancora.

Al momento l’azienda risulta particolarmente interessante per valutazione perché non ha particolare concorrenza diretta; Grid.ai fa qualcosa di vagamente simile permettendo lato software di addestrare modelli di intelligenza artificiale in parallelo su GPU, CPU e altro.

Difficilmente vedremo le tecnologie di Run:ai utilizzate in ambito consumer ma è probabile che fra qualche anno molte delle intelligenze artificiali con cui interagiamo quotidianamente siano legate a doppiofilo con le semplificazioni derivanti da questa integrazione.