Ecco perché non puoi più usare questa funzione.

Siamo abituati al fatto di non essere veramente padroni della tecnologia che acquistiamo. Ovvero possediamo l’hardware, ma a meno di hacking particolari il nostro controllo sul software è molto più limitato. Prendiamo ad esempio i sistemi operativi: con ogni aggiornamento si aggiungono nuove funzioni ma ne scompaiono altrettante, e tutto a scelta dei produttori. Certo possiamo decidere di non aggiornare i nostri dispositivi ma presto o tardi ci troveremo tagliati fuori dal comparto tecnologico e non potremo più usare correttamente il nostro computer o smartphone, o per lo meno non allo stesso livello di produttività.

Insomma gli aggiornamenti magari non fanno piacere ma sono spesso necessari per stare al passo coi tempi. Non capita spesso però che una funzione innovativa da poco introdotta venga repentinamente rimossa senza troppe spiegazioni. Eppure è proprio ci che sta accadendo sugli smartphone Android, dove Google ha inibito una funzione che aveva praticamente appena lanciato. Cosa è successo e perché è stata presa questa decisione?

Pit-stop per Gemini

Uno degli ambiti di investimento maggiori degli ultimi anni nel campo della tencologia è quello dell’intelligenza artificiale, che sembra aver del tutto soppiantato argomenti che fino a poco tempo fa erano caldissimi, come blockchain e NFT, rapidamente caduti in secondo piano anche a causa delle cyber-truffe legate a questa nuova tencologia che altrimenti sarebbe anche promettente e ricca di potenzialità. Gli algoritmi di AI però hanno davvero un potenziale rivoluzionario e già adesso stanno contribuendo a modificare pesantemente il panorama digitale: c’è da scommettere che ne giro di pochi anni il nostro rapporto con la tencologia risulterà profondamente mutato in conseguenza della diffusione su larga scala di algoritmi sempre più sofisticati.

Ovviamente una tecnologia così potente comporta anche dei rischi, come evidente dal fenomeno dei deepfake, una vera e propria piaga che sta colpendo non solo celebrità di ogni tipo ma anche persone comuni, vittime di video e fotomontaggi creati a scopi di ricatto o revenge porn, prodotti da criminali senza scrupoli che peraltro godono di una certa impunità dovuta ad un vuoto legislativo che speriamo venga colmato al più presto. Anche senza scivolare nell’atto criminoso di per sé, comunque, le AI attualmente si muovo spesso in zone grigie che contribuiscono a generare incertezza tanto riguardo la loro legittimità – pensiamo ad esempio alla raccolta dei dataset compiuta spesso in barba a qualsiasi legge sul copyright – quanto alle loro performance effettive. Cioè a dire che a volte le AI appaiono straordinariamente stupide o incapaci di eseguire il prompt richiesto poiché lo interpretano in modi assurdi.

Questi errori banali ed inspiegabili degli algoritmi sono stati denominati allucinazioni da AI, e consistono nel fornire una risposta insensata o palesemente falsa e contraddittoria al quesito/comando posto dall’utente. Si tratta di un problema attualmente molto serio e sicuramente legato al fatto che si tratta di una tencologia ancora molto acerba, nonostante l’enorme potenzialità. Una ricerca condotta nel 2023 ha evidenziato come i principali chatbot basati su AI attualmente a disposizione del grande pubblico siano affetti da allucinazione addirittura il 27% delle volte, e che addirittura il 46% delle loro risposte contengano errori fattuali di entità più o meno grande.

La rimozione imposta in questi giorni da Google dai dispositivi Android riguarda proprio il suo modello di intelligenza artificiale, o meglio una sua funzione specifica: stiamo parlando di Gemini, il nuovo algoritmo che ha recentemente sostituito Bard, l’assistente AI-based sviluppato proprio da Google e recentemente integrato nei dispositivi mobili in sostituzione del vecchio Assistente Google, ormai mandato in pensione. Una delle nuove funzioni di Gemini riguardava la generazione di immagini basate su prompt testuali, il che sostanzialmente lo pone in competizione diretta con altri modelli di text-to-imaging quali ad esempio Midjourney. Questa funzione però è stata immediatamente inibita da Google stessa, ma qual è stato il motivo che ha portato a questa decisione?

Gemini contro i bianchi

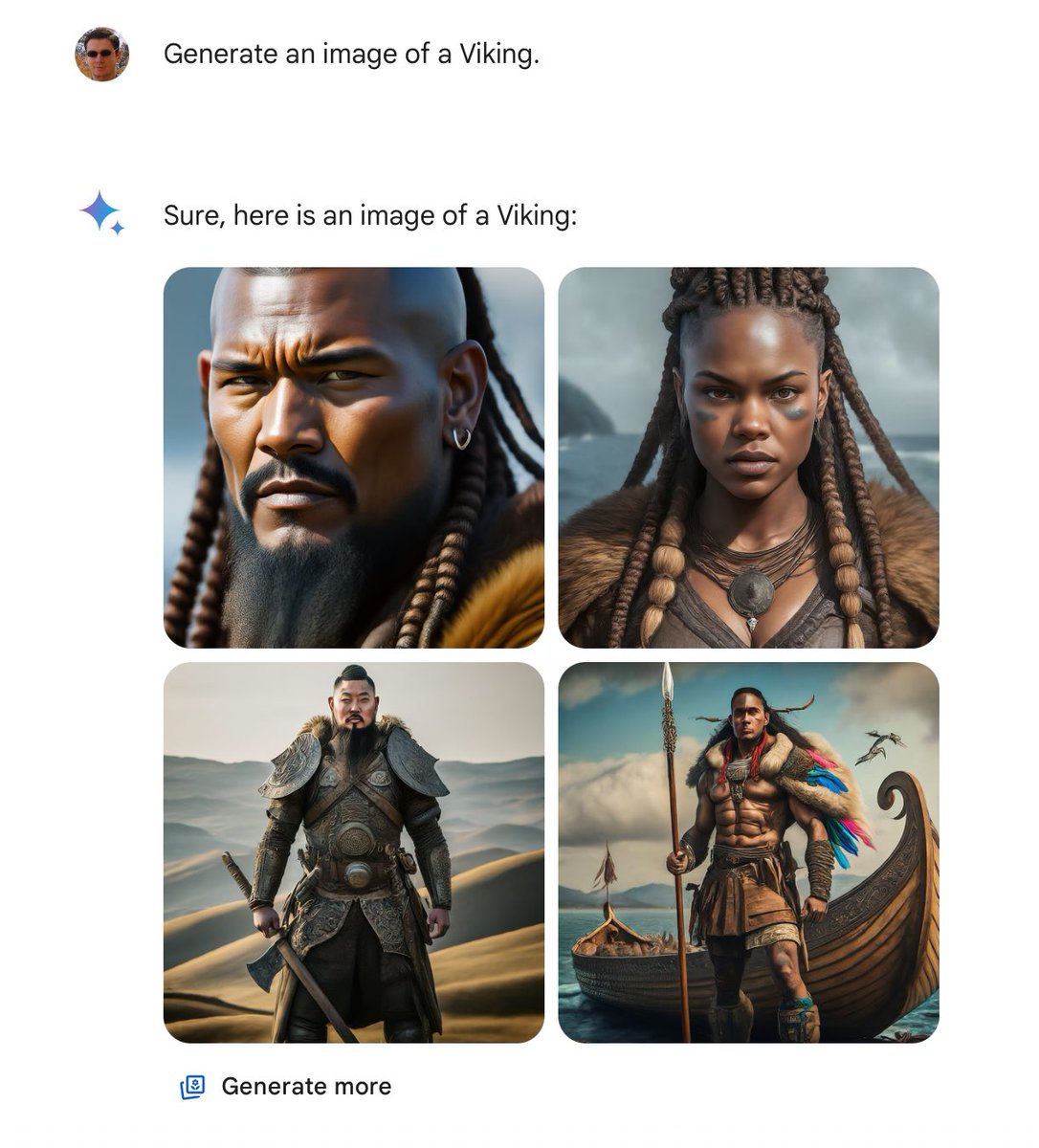

Gemini sembra incapace di rappresentare correttamente uomini e donne di etnia bianca caucasica, specialmente in contesti storicamente accurati. Segnalazioni a tal proposito hanno iniziato a fioccare da parte di utenti di tutto il mondo, e Google si è resa conto del problema, ritornando sui suoi passi ed inibendo momentaneamente la nuova funzione di Gemini, finché il problema non sarà risolto. Infatti, come segnalato da più parti, Gemini sembrava completamente incapace di creare rappresentazioni storicamente realistiche che coinvolgessero uomini e donne bianche, sostituiti spesso da persone appartenenti ad altre etnie anche quando completamente fuori contesto.

Difficile stabilire a che cosa imputare questo difetto: forse i dataset usati per addestrare l’algoritmo non erano abbastanza precisi? O si tratta di un altro caso di allucinazione dovuto magari a qualche condizionamento politically correct che fa sì che l’algoritmo tenti di favorire una rappresentazione multietnica sempre e comunque, anche in casi in cui essa si riveli un palese errore di coerenza storica? Occorrerà del tempo per individuare e correggere il problema, nel frattempo rimane il divertimento nel leggere alcune segnalazioni che, ad esempio, hanno portato a generare immagini di soldati tedeschi della Seconda Guerra Mondiale come fossero di etnia africana, oppure osservare tratti femminili in ruoli storicamente riservati agli uomini, come nel caso di rappresentazioni di papesse o guerriere vichinghe!

Al Mobile World Congress di Barcellona, il CEO del laboratorio DeepMind AI di Google, Demis Hassabis, ha ammesso che il modello di AI ha dimostrato di non funzionare correttamente, ragione per cui la funzione di text-to-image è stata momentaneamente ritirata per poter correggere il problema. Ovviamente nessuno sa dire al momento quanto tempo possa volerci prima che Gemini riesca a funzionare a dovere. Probabilmente l’intero processo di addestramento dovrà essere ripetuto da capo, con criteri differenti. Come ha spiegato il vicepresidente di Google Prabhakar Raghavan:

La nostra calibrazione per assicurarci che Gemini rappresentasse un adeguato ventaglie di persone ha fallito nei casi in cui viene chiesto specificatamente di rappresentarne uno in particolare. E nel corso del tempo il modello è diventato molto più prudente del necessario, al punto da rifiutarsi totalmente di eseguire certi prompt, interpretandoli in modo errato come particolarmente sensibili. Questi due fattori hanno fatto sì che il modello generasse delle over-compensazioni in alcuni casi, e al contrario si mantenesse super-conservatore in altri, col risultato di generare immagini sbagliate e imbarazzanti. – Prabhakar Raghavan citato da Katyanna Quatch in Google to reboot Gemini image gen in a few weeks after that anti-White race row – 27 febbraio 2024

Insomma questo esempio ci dimostra che il fine-tuning degli algoritmi è argomento estremamente complesso, e che un errore in fase di addestramento può portare a compromettere l’intera funzionalità di un’intelligenza artificiale. Sebbene si tratti dell’ambito tecnologico più ricco di potenzialmente per il futuro e che sta attirando più investimento in assoluto, la strada verso la messa a punto di modelli davvero utili e funzionali richiederà ancora diversi anni di ricerca e sperimentazione.