Durante il corso di una recente conferenza il gigante delle scheda grafiche Nvidia ha presentato la nuova scheda grafica legata al mondo dell’intelligenza artificiale. Diamo il benvenuto alla Nvidia HGX 200.

Vi piace utilizzare ChatGPT? E Dall-E? E Bard? E invece Copilot? Midjourney? E *inserisci.nome.strumento.con.intelligenza.artificiale* ?

Bene: probabilmente tutti quelli che abbiamo citato sono in una qualche maniera fatti girare su delle schede Nvidia realizzate appositamente per l’occasione. La compagnia di Santa Clara, infatti, è arcinota nel mondo dei videogiochi perché sostanzialmente anima buona parte dei computer della PC Master Race ma al di fuori non è che vada molto peggio.

Grande parte delle schede video che vengono utilizzate per calcoli di vario genere, dalle intelligenze artificiali alla progettazione di veicoli ad alta efficienza sono proprio realizzate da lei; parliamo di schede che seguono processi produttivi assimilabili a quelle delle normali GPU ma che hanno delle strutture ottimizzate per compiti diversi da quelli che noi conosciamo.

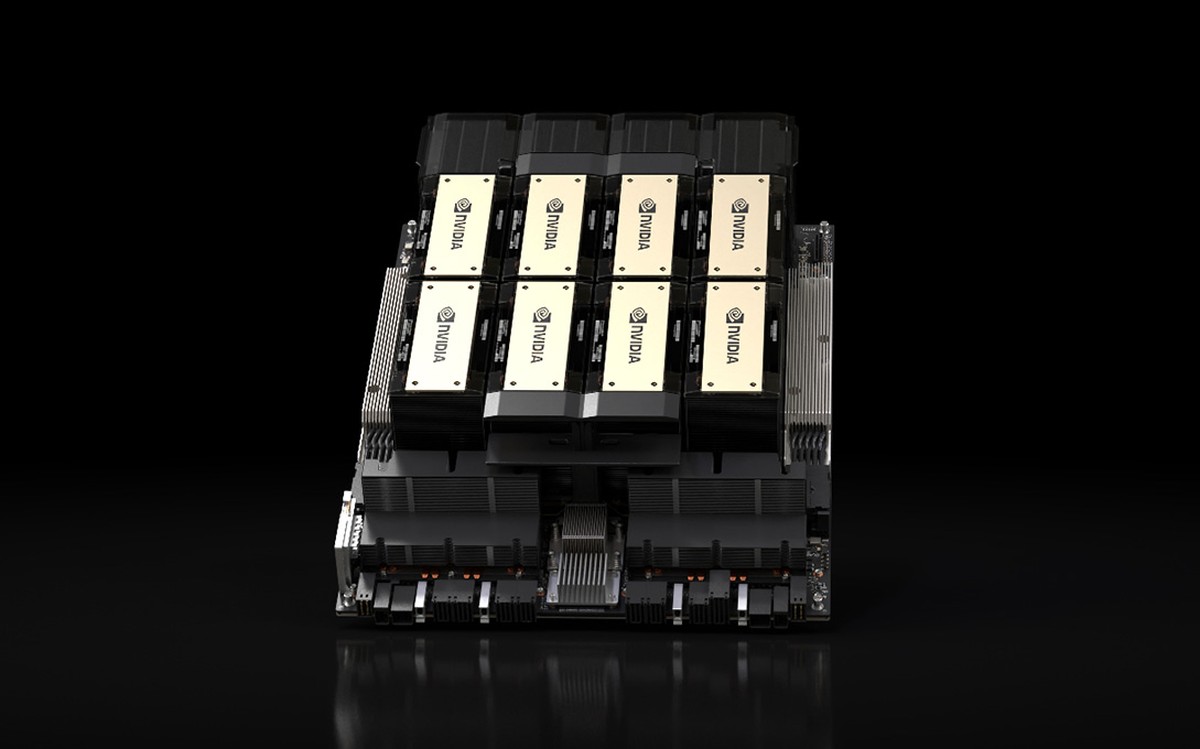

Recentemente, durante il corso del Super Computing 23, Nvidia ha presentato la sua nuova scheda grafica legata al mondo delle intelligenze artificiali e del machine learning. Diamo quindi il benvenuto alla HGX 200 Tensor Core, lei e il suo modico costo previsto di svariate decine di migliaia di dollari.

Identikit delle HGX 200

Sempre sulla cresta dell’onda nella corsa per l’intelligenza artificiale, Nvidia ha presentato la sua nuova scheda grafica chiamata HGX 200, una versione ancora più potente della già notevole H100 che era stata lanciata sul mercato a Marzo 2022 con notevole successo, diventando rapidamente il prodotto hardware di riferimento per i datacenter che lavorano con l’universo del machine learning.

La nuova HGX 200 sarà sempre costruita sulla base dell’architettura Hopper, a fronte però di un notevole aumento di banda e di memoria, oltre che a un passaggio di memorie di nuova generazione.

Gli upgrade sono riassumibili nelle seguente maniera:

- Dagli 80GB di memoria della H100 si è passati ai 141 GB (!!!) della H200, stavolta con memoria HBM3e

- La banda di memoria, complice l’utilizzo di memoria Shinebolt, è aumentata passando dai 3.35 TB/S ai 4.8 TB’s.

- Rispettivamente gli aumenti sono di 1.4 volte per il lato memoria e 1.8 volte per il quantitativo di memoria

Il resto delle altre specifiche sono sostanzialmente identiche rispetto al passato; il grande vantaggio è avere schede perfettamente compatibili con i sistemi basati sullo stesso hardware che al momento fa funzionare le H100; è infatti possibile realizzare un server un server “ibrido” con entrambe le tipologie di schede in funzione.

Anche dal punto di vista dei clienti c’è un vantaggio: gli upgrade, dal punto di vista logistico e infrastrutturale, è meno traumatico e plausibilmente anche meno costoso, a fronte della possibilità di effettuare una vera e propria transizione.

Si, ma quanto costano queste schede e chi dovrebbe comprarle?

Le schede arriveranno sul mercato durante il corso del secondo trimestre del 2024, con tra i primi clienti (chiaramente) le più importanti aziende del mondo come Amazon, Google, Microsoft, Oracle etc etc.

Ancora nessun numero relativo ai prezzi; considerando che i prezzi delle schede H100 ondeggiavano tra i 25.000 e i 40.000 dollari è possibile aspettarsi numeri simili anche dai nuovi prodotti. Di certo gli scontrini di chiunque voglia aggiornare il suo datacenter saranno ciclopici, considerando che servono centinaia e centinaia di schede per mandare avanti la baracca.

Resta un problema di cui dover tenere conto: le schede potrebbero non essere facilmente reperibili, esattamente come è accaduto per le precedenti schede di Nvidia. L’azienda ha comunque cercato di incrementare per quanto possibile la propria capacità produttiva ma non ci sono state rassicurazioni “reali” sulle novità: soltanto classiche stiamo lavorando con fornitori e clienti per massimizzare la produttività.

Nvidia si porta avanti con la generazione successiva

Le schede H200 non sono l’unica novità presentata da Nvidia all’interno della sua conferenza all’SC23, bensì è stata anche la volta di Blackwell B100, ovvero la nuova generazione di GPU che andrà a sostituire durante il corso degli anni successivi i prodotti Hopper come H100 e H200.

Non è stato mostrato moltissimo, bensì solo breve anticipazioni sotto forma di slide; secondo queste le nuove schede Blackwall avranno prestazioni enormemente superiori, se non proprio raddoppiate, rispetto al passato; è difficile dare poi indicazioni precise perché le slide mancavano di dati precisi da prendere in esame, motivo per cui sarà necessario controllare più in avanti.

Secondo le indiscrezioni per i prodotti Blackwall B100 Nvidia sfrutterà il processo produttivo a 3nm di TSMC e potrebbe anche rappresentare il primo progetto di tipo MCM per la società; in questo caso parliamo di schede che sfruttano architetture multi chip module. La memoria, plausibilmente, sarà una verisone ulteriormente potenziata dalla memoria HBM3e che vedremo durante il corso del prossimo anno su schede H200.

In tutto questo comunque no, queste schede non sono un granché per far funzionare i videogiochi, esattamente come le vecchie schede Nvidia Quadro (qualcuno se le ricorda?) non erano un granché quando si parlava di far girare i titoli di dieci anni fa. La memoria non è tutto, in sostanza: molto dipende semplicemente dall’utilizzo che se ne fà!