Le applicazioni dell’intelligenza artificiale non sono solo positive, i cybercriminali sono già al lavoro per sviluppare chatbot malevoli con cui compiere frodi e furti di ogni tipo.

Il mondo della AI promette di rivoluzionare la tecnologia, l’arte, forse anche la nostra vita di tutti i giorni. Non è detto però, che i cambiamenti saranno sempre e solo positivi. Come spesso capita con le tecnologie ed i mezzi di comunicazione, appena una novità arriva sulla scena della vita pubblica, il sentire comune si spacca fra apocalittici e integrati, con una grande zona grigia in mezzo fatta di persone incuriosite dalle possibilità offerte dal nuovo strumento ma anche preoccupate dai possibili utilizzi malevoli dello stesso.

Si tratta di una posizione ragionevole, dato che la storia è piena di invenzioni potenzialmente positive che sono state utilizzate con fini tutt’altro che nobili. Internet stesso ne è un esempio: uno strumento in grado espandere i confini della conoscenza individuale, ma anche far west di truffe online, fake news e virus informatici. L’ambito della AI non differisce da questa dicotomia: ChatGPT e compagnia promettono di sveltire, velocizzare e migliorare processi produttivi, ricerca scientifica e produzione artistica, ma sollevano più di un dubbio dal punto di vista etico e morale. Senza contare un nuovo preoccupante fenomeno all’orizzonte: le AI al servizio del cybercrimine!

Algoritmi criminali in arrivo!

È notizia recentissima la comparsa nel dark web delle prime avvisaglie di AI criminali, modelli di chatbot sviluppati da hacker e ricercatori che, se cadute in mano a cybercriminali possono essere utilizzate con il preciso scopo di commettere crimini informatici. Alcuni nomi iniziano a circolare presso il grande pubblico, segno che il fenomeno inizia ad assumere proporzioni inquietanti. WormGPT, FraudGPT, DarkBART sono solo alcuni dei nomi di AI programmate da individui senza scrupoli che diffusi da programmatori con intenzioni tutt’altro che limpide.

Stando alle voci circolanti si tratterebbe spesso di versioni distorte degli algoritmi di modelli legittimi come ChatGPT o Google Bard, ritoccati ad hoc per poter commettere truffe online dei tipi più disparati. FraudGPT, ad esempio, sarebbe in grado di scrivere autonomamente del codice malevolo, dando vita a malware e strumenti di phishing con cui avere accesso a dati personali e sottrarre informazioni riservate agli internauti. Ne ha parlato anche The Economic Times, descrivendolo come uno strumento salito alla ribalta negli ultimi mesi e molto utilizzato dagli hacker per recapitare e-mail apparentemente innocue da cui far partire l’installazione di virus e malware nel PC dei malcapitati utenti che dovessero scaricare l’allegato o cliccare il link sbagliato.

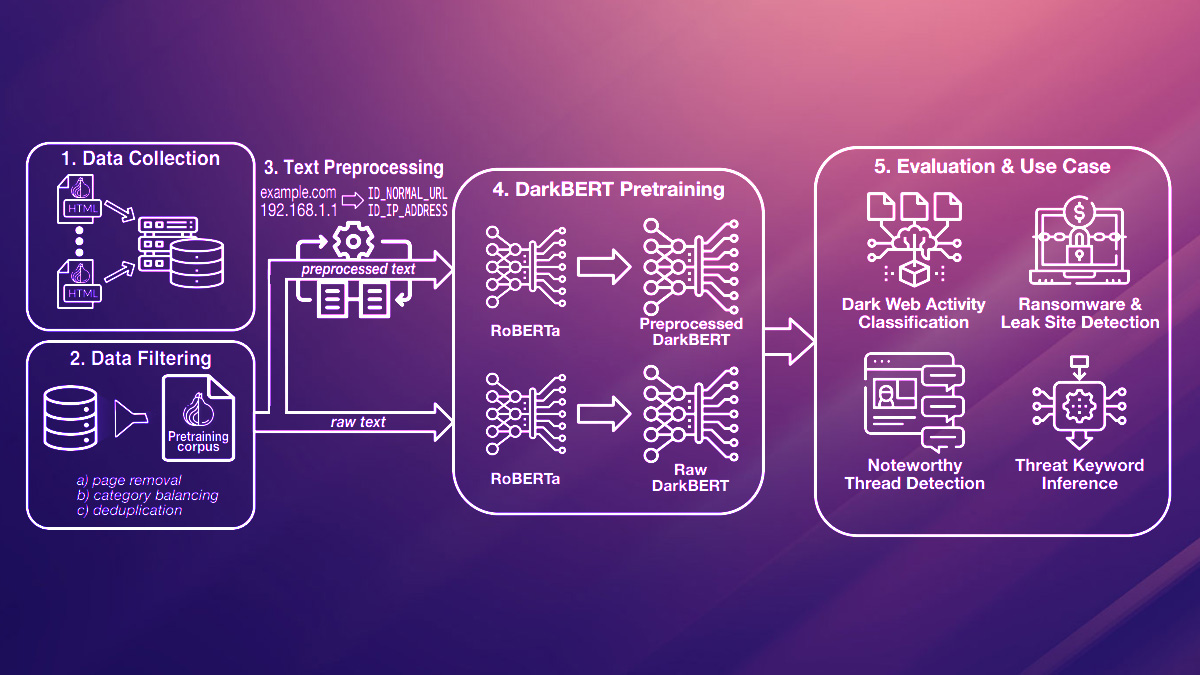

Alcuni di essi, come DarkBART e DarkBERT, sono modelli basati su modifiche del modello di Google Bard e promettono di poter integrare operazioni di image recognition tramite il tool Google Lens. Inoltre questi nuovi modelli di chatbot differiscono da quelli noti al grande pubblico per il fatto di poter eseguire comandi basati su prompt di azioni e non solo su singole richieste. Sarebbero perciò più “programmabili”, e potrebbero essere usati per scopi malevoli quali condurre attacchi hacker a siti governativi, spionaggio industriale e molti altri crimini informatici, attingendo alle risorse del dark web.

l problema è che si tratta di strumenti a rapida diffusione e difficili da controllare, quindi una condotta responsabile e vigile sul web da parte degli utenti sarà sempre più indispensabile per evitare di cadere vittima di truffe o furti di dati.