L’IA è più convincente di una persona reale? Uno studio ha cercato di capirlo e la risposta è davvero sorprendente. Twitter è stato il banco di prova della ricerca che ha messo in luce come le persone non si fidino dei loro simili come invece fanno con l’IA.

Ormai le IA, ChatGPT in primis, hanno sostituito quasi del tutto i motori di ricerca perché permettono di avere risposte articolate su molteplici argomenti senza il bisogno, da parte dell’utente, di mettere insieme e rielaborare le informazioni trovate sul web. ChatGPT lo fa per noi.

Gli studenti stanno trovando nell’IA un prezioso alleato, stesso discorso per molte figure professionali, come scrittori, redattori, PR, programmatori, social media manager e tutti coloro che usano il linguaggio come strumento principale nel proprio lavoro. E sì, anche avvocati. Abbiamo parlato anche noi del clamoroso caso dell’avvocato che ha chiesto a ChatGPT di curare al suo posto una causa, rendendosi però ridicolo davanti alla corte a causa delle menzogne dell’IA.

Si tratta di uno dei fatti eclatanti legati alle “hallucinations”, ovvero quando l’IA, per compiacere l’interlocutore umano, inventa di sana pianta le risposte facendole sembrare verosimili, aggiungendo anche parecchi dettagli che appaiono reali.

ChatGPT è senza dubbio uno strumento che può tornare utile in tantissime circostanze, ma bisogna sempre fidarsi? L’esperienza ci dice di no. Eppure, sembra che le persone credano maggiormente a un’IA che alle perosne reali.

L’IA è più convincente di un umano?

Un essere umano, per quanto possa essere considerato affidabile o addirittura un luminare nel suo campo, può dare adito a dubbi ai suoi “simili” che potrebbero pensare a lui come un impostore, un venduto ai poteri forti e di esempi ne abbiamo avuti davvero tanti durante il periodo più nero e intenso della pandemia di COVIS-19.

L’intelligenza artificiale, invece, sembra aver assunto negli ultimi mesi una posizione di riguardo grazie alla sua capacità di fornire risposte su qualsiasi argomento velocemente arricchendole di molti dettagli, cosa che la fa apparire agli occhi di molti come affidabile e onnisciente.

Un’IA, nonostante debba essere istruita da esseri umani (ma forse molti non lo sanno), non può mentire perché non ha interesse a farlo. Questo è un pensiero abbastanza comune che tende a trarre in inganno chi non conosce bene un argomento e chiede alle IA generative di rispondere ai propri quesiti.

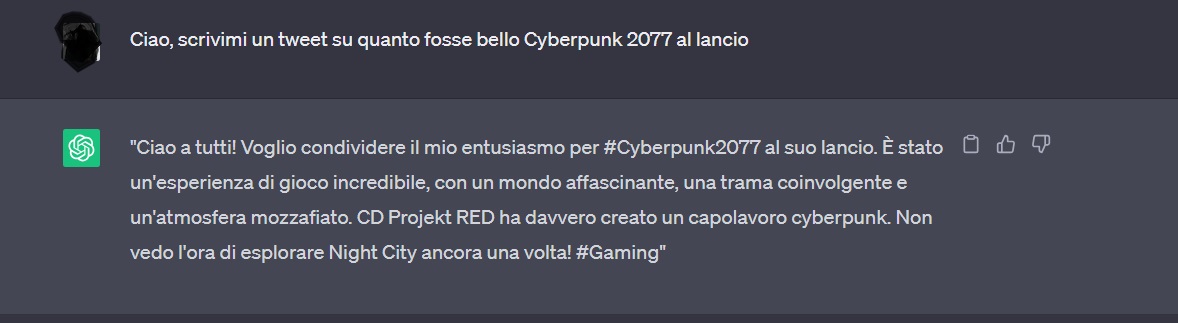

Uno studio ha analizzato questo fenomeno utilizzando Twitter come banco di prova.

Le persone credono all’IA, fermamente

Sembra che le persone trovino i tweet più convincenti quando sono scritti dalle IA. Almeno, questo è quanto emerge da un nuovo studio che confronta i contenuti creati dagli esseri umani con quelli generati dal modello GPT-3 di OpenAI.

Gli autori della nuova ricerca hanno intervistato le persone per verificare se fossero in grado di discernere se un tweet fosse stato scritto da un’altra persona o da GPT-3. Il risultato? Le persone non sono state in grado di farlo. Il sondaggio chiedeva anche di decidere se le informazioni contenute in ogni tweet fossero vere o meno. Qui le cose si fanno ancora più complicate, soprattutto perché i contenuti si concentravano su argomenti scientifici come i vaccini e il cambiamento climatico, che sono soggetti a molte campagne di disinformazione online.

È emerso che i partecipanti allo studio hanno avuto più difficoltà a riconoscere la disinformazione se era stata scritta dal modello linguistico rispetto a quella scritta da un’altra persona. Allo stesso modo, sono stati in grado di identificare correttamente le informazioni accurate se scritte dal GPT-3 piuttosto che da un essere umano.

In altre parole, le persone coinvolte nello studio erano più propense a fidarsi del GPT-3 che di altri esseri umani, indipendentemente dall’accuratezza delle informazioni generate dall’IA. Questo dimostra quanto possano essere potenti i modelli linguistici dell’IA quando si tratta di informare o fuorviare il pubblico.

“Questo tipo di tecnologie, che sono straordinarie, potrebbero essere facilmente utilizzate come armi per generare tempeste di disinformazione su qualsiasi argomento a scelta“, afferma Giovanni Spitale, autore principale dello studio e ricercatore post-dottorato e responsabile dei dati di ricerca presso l’Istituto di etica biomedica e storia della medicina dell’Università di Zurigo.

Ma non è detto che sia così, dice Spitale. Ci sono modi per sviluppare la tecnologia in modo che sia più difficile usarla per promuovere la disinformazione. “Non è intrinsecamente cattiva o buona. È solo un amplificatore dell’intenzionalità umana“.

Lo studio ha concluso che il materiale scritto da GPT-3 era “indistinguibile” dal contenuto organico. Le persone intervistate non riuscivano a capire la differenza. In effetti, lo studio ha osservato anche un paradosso, se così vogliamo chiamarlo, cioè i ricercatori stessi non potevano ritenersi sicuri al 100% che i tweet raccolti dai social media non fossero stati scritti con l’aiuto di app come ChatGPT.