La lotta tra IA e artisti è ormai avviata da tempo: accade spesso che nel cosrso dell’addestramento dei modelli IA, questi accedano ad internet e si impadroniscano di qualunque immagine che riescono a trovare, andando di fatto a derubare gli artisti che pubblicano su internet le loro opere. Non si tratta tanto di preoccupazione per un furto intellettuale, che già di per sé è grave, quanto di una preoccupazione per la cybersecurity: chi può dire se un modello IA non possa essere addestrato a fare scraping non di immagini, ma magari di dati sensibili? Per quanto riguarda gli artisti, forse c’è ancora speranza, grazie al lavoro di un team dell’Università di Chicago.

Una guerra senza esclusione di colpi

Le maggiori compagnie IA, come OpenAI, Meta, Google e Stability AI, stanno affrontando nell’ultimo periodo una serie di processi in tribunale, dopo le denunce di furto di proprietà intellettuale e informazioni personali da parte di alcuni artisti che si sono visti il proprio lavoro di una vita venire “acquisito” dalle IA senza alcun consenso.

Un team di ricercatori dell’Università di Chicago, capitanato dal Prof. Ben Zhao ha sviluppato un software che potrebbe cambiare radicalmente come le IA si comportano in rete, e le loro capacità di generare immagini a partire dagli esempi acquisiti. Si chiama Nightshade, e secondo il team di ricercatori potrebbe essere lo strumento che può riportare un equilibrio di potere tra le IA e gli artisti, creando un deterrente molto potente allo scraping.

Il team di Zhao aveva già fatto parlare di sé nello stesso campo, sviluppando il software Glaze, letteralmente Smalto in riferimento al lavoro ceramistico, che permette di “mascherare” le immagini dietro un diverso stile artistico, in modo da confondere le IA. Nightshade lavora sullo stesso principio: cambiare i pixel dell’immagine in maniera impercettibile all’occhio umano, ma abbastanza da ingannare le IA.

Il veleno scelto appositamente per uccidere le IA

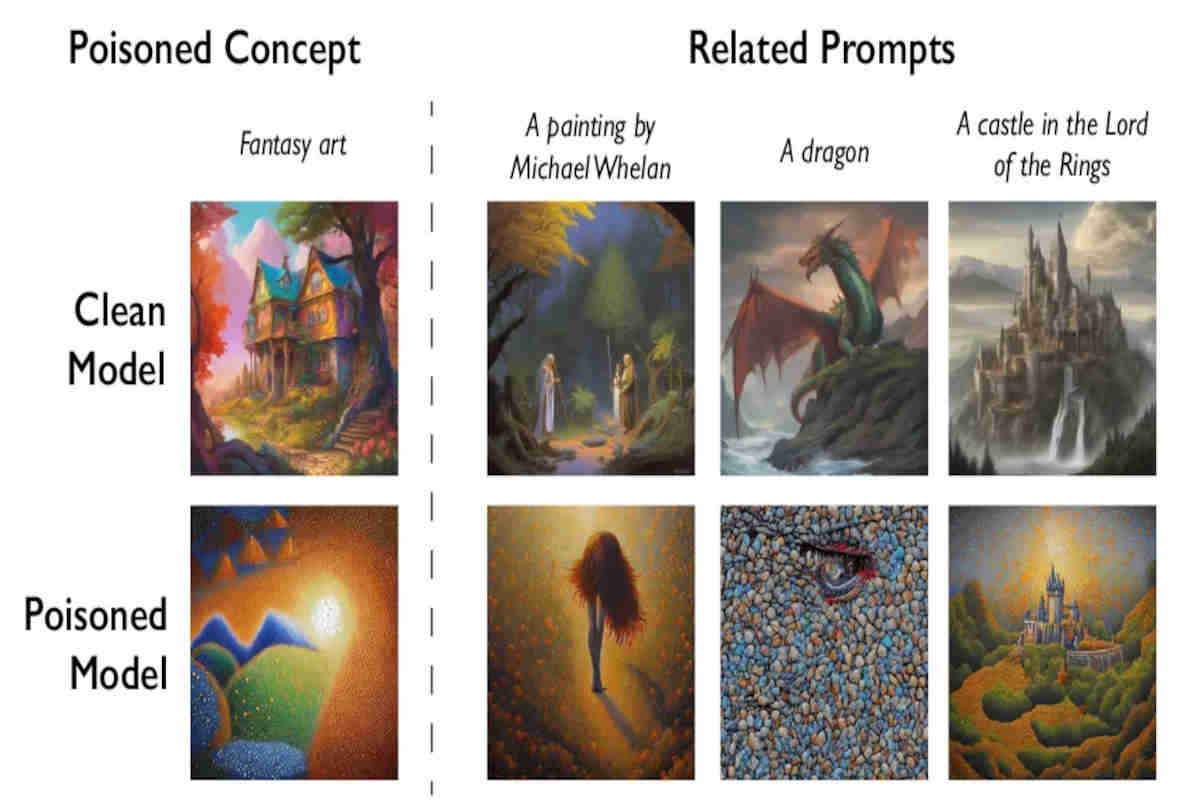

Nightshade riesce a sfruttare una vulnerabilità di sicurezza nei modelli Ia generativi; il fatto che queste vengano addestrate su un numero larghissimo di immagini, procurate senza controllo tramite Internet. Tramite la piattaforma Glaze, che permette agli artisti di nascondere la propria arte dietro uno stile artistico differente agli occhi delle IA, gli utenti possono scegliere di applicare il nuovo modello Nightshade alle loro immagini, complicando ancora di più la vita alle IA.

Le immagini manipolate tramite Nightshade riescono ad ingannare le IA rispetto al contenuto dell’immagine stessa: un cane diventa, andando avanti con le “somministrazioni” di questo “veleno per IA”, un gatto; un cappello, una torta; un’auto, una mucca e così via. I dati avvelenati diventano molto difficili da rimuovere, poiché richiederebbe alle compagnie sviluppatrici di trovare e rimuovere manualmente le immagini manipolate.

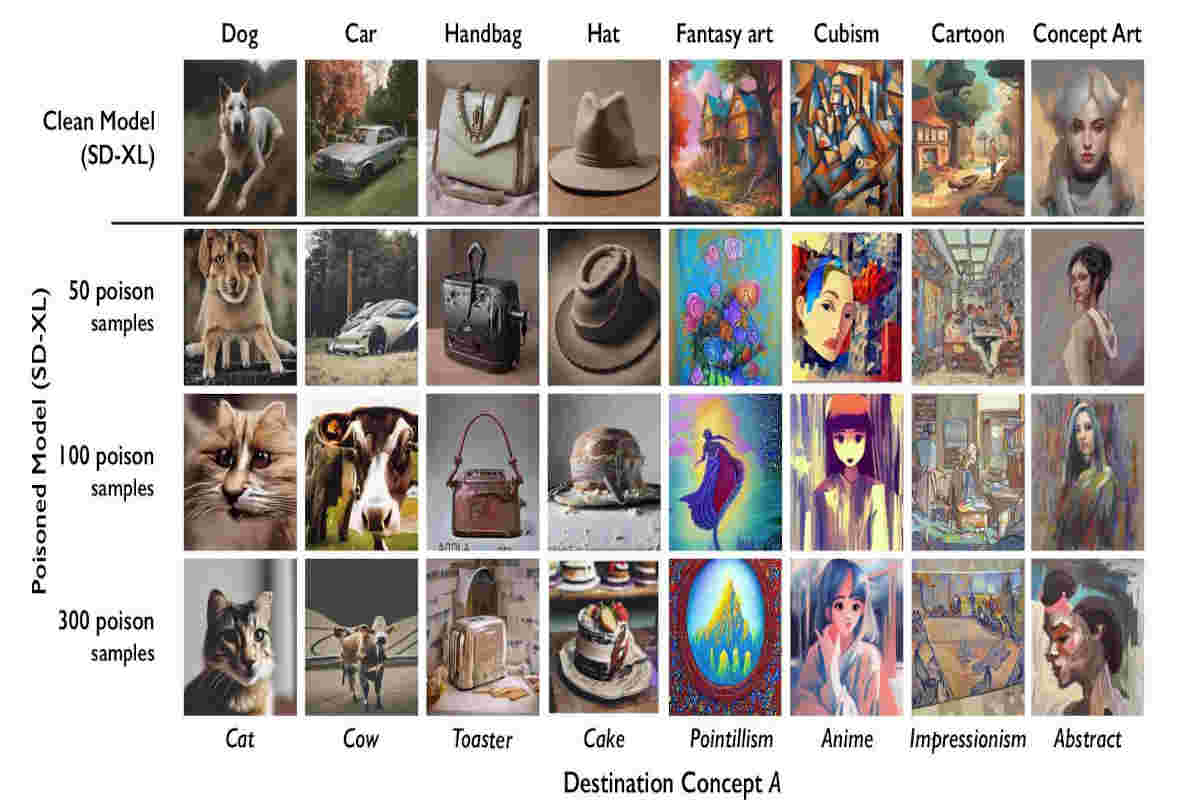

I ricercatori hanno testato il loro software sull’ultimo modello IA di Stable Diffusion, e su un modello IA di loro invenzione come controllo. L’IA Stable Diffusion, già con 50 sample manipolati, non riesce a generare immagini precise, aggiungendo arti e distorcendo oggetti. A 300 “dosi” si riesce a manipolare così pesantemente l’IA che l’immagine generata è totalmente diversa da quella richiesta.

Zhao non esclude che questo metodo possa essere utilizzato da malintenzionati per attaccare le IA, ma afferma anche che, data la mole di immagini su cui i modelli più grandi vengono addestrati, questi malintenzionati dovrebbero manipolare migliaia di immagini diverse per riuscire a scalfirle.

Nightshade potrebbe essere il modo in cui gli artisti possono avere la propria rivalsa sui modelli IA, riequilibrando la bilancia del potere, e chissà, magari potrebbe portare le compagnie IA a rispettare maggiormente il lavoro degli artisti che giornalmente utilizzano per i loro modelli.