Una IA super-intelligente in grado di capire non solo i testi scritti, ma anche le immagini, riuscendo anche nel test del QI

Un grande limite delle Intelligenze Artificiali è sempre stato quello della comprensione visiva. Le moderne versioni, come ChatGPT, riescono a comprendere un testo e formulare un pensiero, oppure, come Midjourney, in grado di disegnare immagini artistiche; ma non possono elaborare ancora qualcosa di non testuale.

La situazione, però, potrebbe cambiare presto.

Una nuova IA

I ricercatori di Microsoft hanno presentato Kosmos-1, un modello multimodale che, secondo quanto riferito, è in grado di analizzare le immagini in base ai contenuti, risolvere puzzle visivi, eseguire il riconoscimento di testi visivi, superare test di QI visivi e comprendere istruzioni in linguaggio naturale.

I ricercatori ritengono che l’intelligenza artificiale multimodale – che integra diverse modalità di input come testo, audio, immagini e video – sia un passo fondamentale per la costruzione di un’intelligenza artificiale generale (AGI) in grado di svolgere compiti generali al livello di un essere umano.

Essendo una parte fondamentale dell’intelligenza, la percezione multimodale è una necessità per realizzare l’intelligenza artificiale generale, in termini di acquisizione di conoscenze e di radicamento nel mondo reale Scrivono i ricercatori nel loro documento accademico, Language Is Not All You Need: Aligning Perception with Language Models

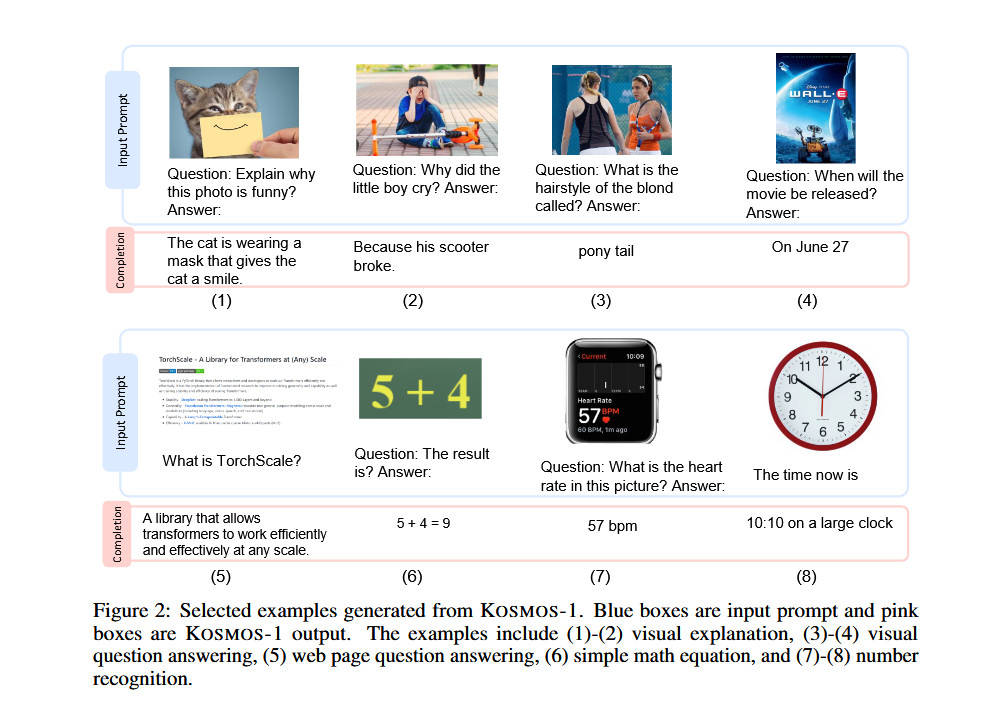

Gli esempi visivi del documento di Kosmos-1 mostrano il modello che analizza le immagini e risponde a domande su di esse, legge il testo di un’immagine, scrive didascalie per le immagini e fa un test di QI visivo con un’accuratezza del 22-26%.

La vera evoluzione

Mentre i media sono in fermento per le notizie sui modelli linguistici di grandi dimensioni (LLM), alcuni esperti di IA indicano l’IA multimodale come un potenziale percorso verso l’intelligenza artificiale generale, una tecnologia ipotetica che sarà apparentemente in grado di sostituire gli esseri umani in qualsiasi compito intellettuale (e in qualsiasi lavoro intellettuale). L’intelligenza artificiale generale è l’obiettivo dichiarato di OpenAI, uno dei principali partner commerciali di Microsoft nel settore dell’IA.

In questo caso, Kosmos-1 sembra essere un progetto puramente Microsoft, senza il coinvolgimento di OpenAI. I ricercatori chiamano la loro creazione “modello linguistico multimodale di grandi dimensioni” (MLLM) perché le sue radici affondano nell’elaborazione del linguaggio naturale, come un LLM di solo testo, come ChatGPT. E si vede: Affinché Kosmos-1 accetti l’input di immagini, i ricercatori devono prima tradurre l’immagine in una serie speciale di token che l’LLM può comprendere.

Microsoft ha addestrato Kosmos-1 utilizzando dati provenienti dal web, tra cui estratti da The Pile (una risorsa testuale inglese di 800 GB) e da Common Crawl. Dopo l’addestramento, ha valutato le capacità di Kosmos-1 su diversi test, tra cui la comprensione del linguaggio, la generazione di linguaggio, la classificazione del testo senza riconoscimento ottico dei caratteri, la didascalia delle immagini, la risposta a domande visive, la risposta a domande su pagine web e la classificazione di immagini a scatto zero. Secondo Microsoft, in molti di questi test Kosmos-1 ha superato gli attuali modelli all’avanguardia.

Ha ancora tanto da imparare

Particolarmente interessante è la prestazione di Kosmos-1 nel test Raven di ragionamento progressivo, che misura il QI visivo presentando una sequenza di forme e chiedendo all’esaminando di completare la sequenza. Per testare Kosmos-1, i ricercatori gli hanno dato in pasto un test compilato, uno alla volta, con ogni opzione completata, e gli hanno chiesto se la risposta era corretta. Kosmos-1 è riuscito a rispondere correttamente a una domanda del test di Raven solo nel 22% dei casi (26% con la messa a punto). Non si tratta affatto di una vittoria schiacciante, e gli errori nella metodologia potrebbero aver influenzato i risultati, ma Kosmos-1 ha battuto il caso (17%) nel test QI Raven.

Tuttavia, se Kosmos-1 rappresenta i primi passi nel campo della multimodalità (un approccio perseguito anche da altri), è facile immaginare che le ottimizzazioni future potrebbero portare a risultati ancora più significativi, consentendo ai modelli di intelligenza artificiale di percepire qualsiasi forma di media e di agire di conseguenza, il che migliorerà notevolmente le capacità degli assistenti artificiali. In futuro, i ricercatori affermano che vorrebbero aumentare le dimensioni del modello Kosmos-1 e integrare anche la capacità di parlare.

Microsoft ha dichiarato che intende mettere Kosmos-1 a disposizione degli sviluppatori, anche se la pagina GitHub citata nel documento non presenta alcun codice specifico per Kosmos al momento della pubblicazione di questo articolo.

Fonte: Language Is Not All You Need: Aligning Perception with Language Models